Hadoop集群搭建前安装准备参考:

一、Hadoop系统应用之安装准备(一)(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)

一、Hadoop系统应用之安装准备(二)(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)

Hadoop集群搭建过程参考:

二、Hadoop系统应用之Hadoop集群搭建(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)

文章目录

- 一、Hadoop高可用集群简介

- 二、Hadoop高可用集群的搭建

- 1、重新布置三个服务器

- 2、安装Zookeeper

- 3、修改core-site.xml文件

- 4、修改hdfs-site.xml文件

- 5、修改yarn-site.xml文件

- 6、修改slaves文件

- 7、配置文件分发

- 8、启动Hadoop高可用集群

一、Hadoop高可用集群简介

在高可用HDFS中,通常有两台或两台以上机器充当NameNode,无论何时,都要保证至少有一台处于活动(Active)状态,一台处于备用(Standby)状态。Zookeeper为HDFS集群提供自动故障转移的服务,给每个NameNode都分配一个故障恢复控制器(简称ZKFC),用于监控NameNode状态。若NameNode发生故障,Zookeeper通知备用NameNode启动,使其成为活动状态处理客户端请求,从而实现高可用。

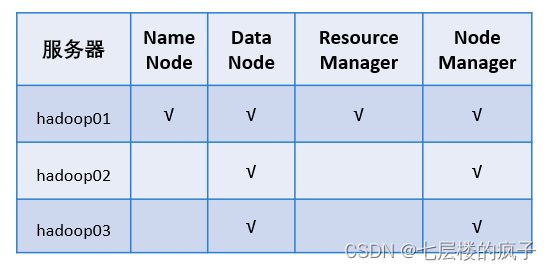

前面搭建的Hadoop集群部署情况如下所示。

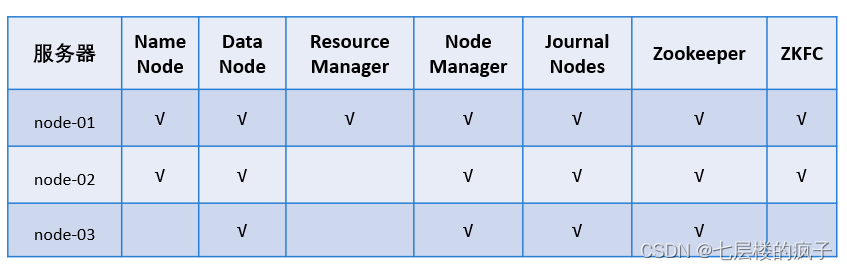

HDFS的高可用集群是由三台虚拟机部署,具体部署情况如下所示。

二、Hadoop高可用集群的搭建

1、重新布置三个服务器

在服务器的Hadoop集群的搭建过程中,可参考前面提供的操作实验文档:

一、Hadoop系统应用之安装准备(一)(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)

一、Hadoop系统应用之安装准备(二)(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)

二、Hadoop系统应用之Hadoop集群搭建(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)

注意,为了方便跟前面搭建的集群进行区分,需要做以下调整:

- 三个节点的名称分别设为node-01、node-02和node-03;

- 网络配置时将三个服务器的hostname修改为node-01、node-02和node-03;

- 设置IP映射时,可将node-01设为192.168.121.137,node-02设为192.168.121.138,node-03设为192.168.121.139。

2、安装Zookeeper

具体操作,可参考前面提供的操作实验文档:

六、Hadoop系统应用之Zookeeper分布式协调服务(一)(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)

注意事项:

- 将三个服务器的hostname修改为node-01、node-02和node-03;

- 在配置文件zoo.cfg时,将对应内容设置为:

server.1=node-01:2888:3888 server.2=node-02:2888:3888 server.3=node-03:2888:3888

- 安装完成后,依次在三个节点上使用如下指令关闭防火墙与防火墙开机启动。

service iptables stop chkconfig iptables off

3、修改core-site.xml文件

使用如下指令进入相关路径并修改此文件:

cd /export/servers/hadoop-2.7.4/etc/hadoop vi core-site.xml

将文件内容修改为如下部分:

fs.defaultFS hdfs://ns1 hadoop.tmp.dir /export/servers/hadoop-2.7.4/tmp ha.zookeeper.quorum node-01:2181,node-02:2181,node-03:2181 4、修改hdfs-site.xml文件

指令如下:

vi hdfs-site.xml

将文件内容修改为如下部分:

dfs.replication 2 dfs.namenode.name.dir file:/export/data/hadoop/name dfs.datanode.data.dir file:/export/data/hadoop/data dfs.webhdfs.enabled true dfs.nameservices ns1 dfs.ha.namenodes.ns1 nn1,nn2 dfs.namenode.rpc-address.ns1.nn1 node-01:9000 dfs.namenode.http-address.ns1.nn1 node-01:50070 dfs.namenode.rpc-address.ns1.nn2 node-02:9000 dfs.namenode.http-address.ns1.nn2 node-02:50070 dfs.namenode.shared.edits.dir qjournal://node-01:8485;node-02:8485;node-03:8485/ns1 dfs.journalnode.edits.dir /export/data/hadoop/journaldata dfs.ha.automatic-failover.enabled true dfs.client.failover.proxy.provider.ns1 org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider dfs.ha.fencing.methods sshfence shell(/bin/true) dfs.ha.fencing.ssh.private-key-files /root/.ssh/id_rsa dfs.ha.fencing.ssh.connect-timeout 30000 5、修改yarn-site.xml文件

指令如下:

vi yarn-site.xml

将文件内容修改为如下部分:

yarn.nodemanager.resource.memory-mb 2048 yarn.scheduler.maximum-allocation-mb 2048 yarn.nodemanager.resource.cpu-vcores 1 yarn.resourcemanager.ha.enabled true yarn.resourcemanager.cluster-id yrc yarn.resourcemanager.ha.rm-ids rm1,rm2 yarn.resourcemanager.hostname.rm1 node-01 yarn.resourcemanager.hostname.rm2 node-02 yarn.resourcemanager.zk-address node-01:2181,node-02:2181,node-03:2181 yarn.nodemanager.aux-services mapreduce_shuffle 6、修改slaves文件

node-01 node-02 node-03

7、配置文件分发

将配置好的文件分发给node-02和node-03。

scp -r /export/ node-02:/ scp -r /export/ node-03:/

8、启动Hadoop高可用集群

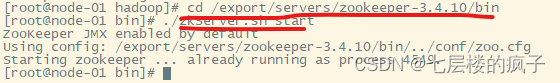

(1)启动集群中各个节点的Zookeeper服务,命令如下:

cd /export/servers/zookeeper-3.4.10/bin ./zkServer.sh start

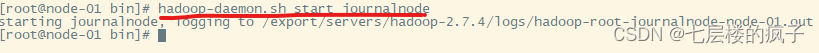

(2)启动集群各个节点监控NameNode的管理日志的JournalNode,命令如下:

hadoop-daemon.sh start journalnode

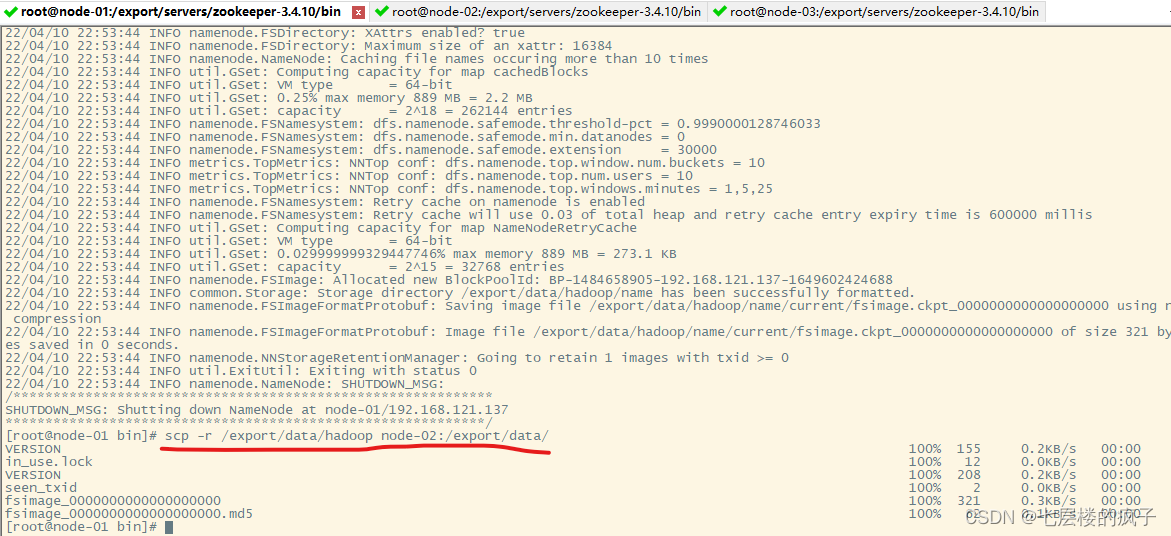

(3)在node-01节点格式化Namenode,并将格式化后的目录复制到name-02中,命令如下(仅首次启动):

hadoop namenode -format scp -r /export/data/hadoop node-02:/export/data/

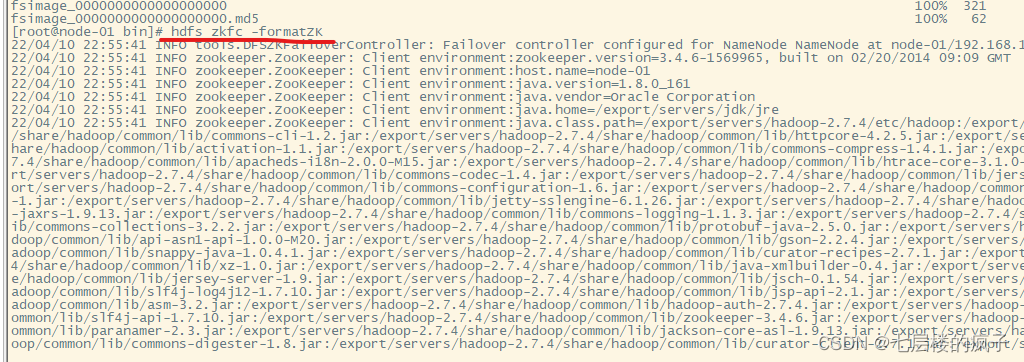

(4)在node-01节点上格式化ZKFC,命令如下(仅首次启动):

hdfs zkfc -formatZK

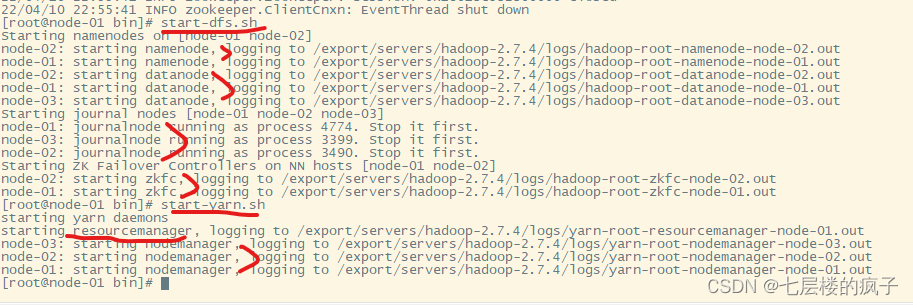

(5)在node-01上分别启动HDFS和YARN,命令如下:

start-dfs.sh start-yarn.sh

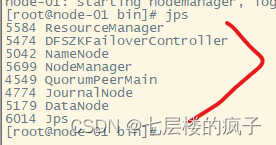

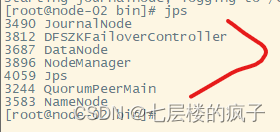

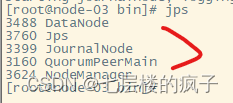

(6)使用命令jps查看各个服务的启动情况。

node-01:

node-02:

node-03:

参考文献:黑马程序员.Hadoop大数据技术原理与应用[M].北京:清华大学出版社,2019.

后续Hive数据仓库应用的学习链接:

一、Hive数据仓库应用之Hive部署(超详细步骤指导操作,WIN10,VMware Workstation 15.5 PRO,CentOS-6.7)

猜你喜欢

网友评论

- 搜索

- 最新文章

- 热门文章