系统环境为 CentOS 7.5 版本。

-

安装 Java 8。

-

安装 Hadoop 集群,Hadoop 建议选择 Hadoop 2.7.5 以上版本。

-

配置集群节点服务器间时间同步以及免密登录,关闭防火墙。

-

flink版本flink-1.14.0。

-

Scala版本scala_2.12。

flink安装包:flink-1.14.0-bin-scala_2.12.tgz

安装包位置:/opt/software/flink-1.14.0-bin-scala_2.12.tgz

解压位置:/opt/module/

单节点模式(不推荐)

解压压缩包

最简单的启动方式,其实是不搭建集群,直接本地启动。本地部署非常简单,直接解压安装包就可以使用,不用进行任何配置;一般用来做一些简单的测试tar -zxvf /opt/software/flink-1.14.0-bin-scala_2.12.tgz -C /opt/module/

进入解压目录

cd /opt/module/flink-1.14.0/

启动/关闭集群

启动Hadoop集群

dfs-start.sh yarn-start.sh

启动/停止flink集群

./bin/start-cluster.sh ./bin/stop-cluster.sh

查看集群运行结果:

[root@bigdata1 flink-1.14.0]# jps

1992 StandaloneSessionClusterEntrypoint

2269 TaskManagerRunner

2381 Jps

访问web页面

https://bigdata1:8081

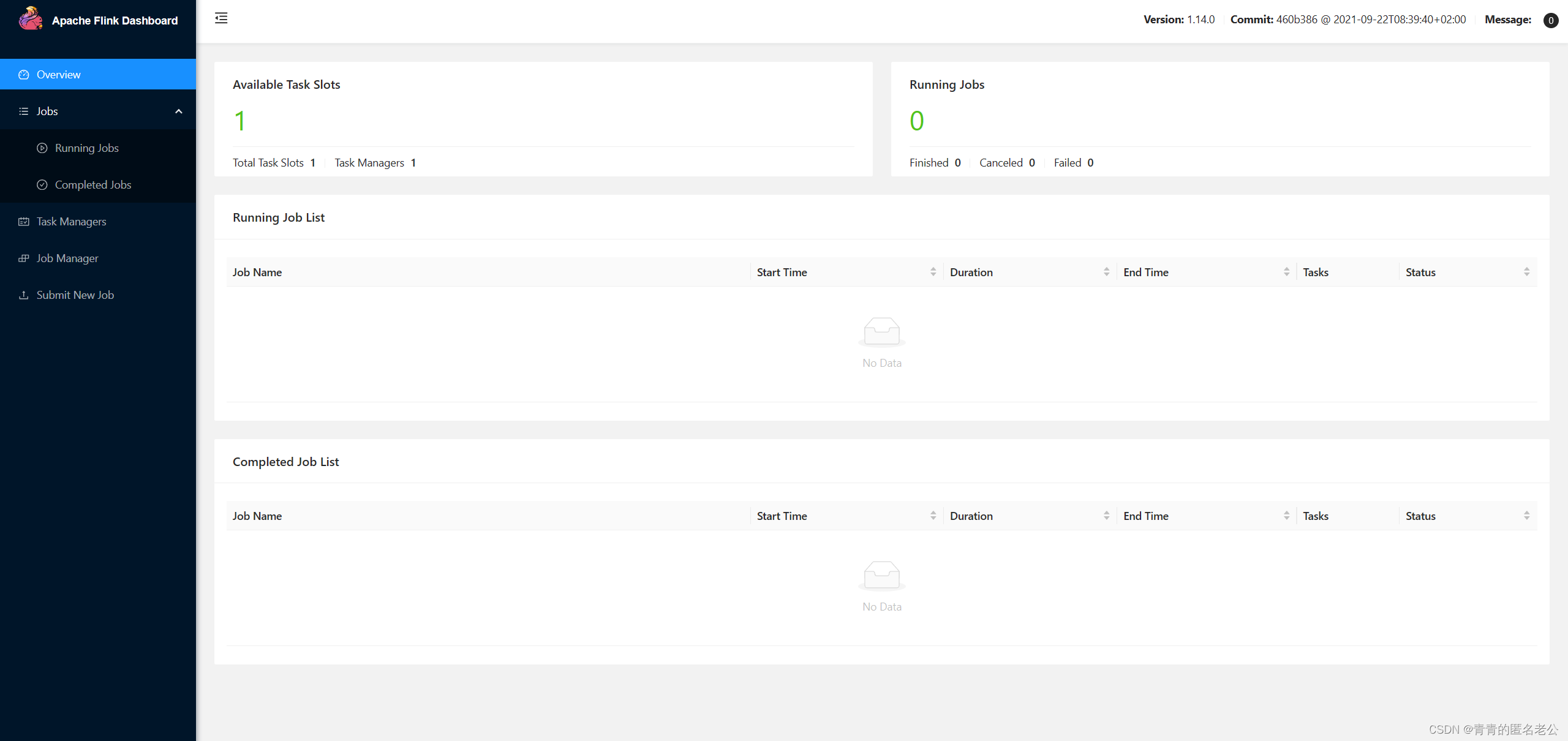

节点位于bigdata1

默认端口号为8081

集群模式(不推荐)

Flink 是典型的 Master-Slave 架构的分布式数据处理框架,其中 Master 角色对应着JobManager,Slave 角色则对应 TaskManager

集群角色分配:

节点服务器 bigdata1 bigdata2 bigdata3 角色 JobManager TaskManager TaskManager 解压压缩包

tar -zxvf /opt/software/flink-1.14.0-bin-scala_2.12.tgz -C /opt/module/

进入解压目录

cd /opt/module/flink-1.14.0/

修改配置文件

flink-conf.yaml

vim /flink-1.14.0/conf/flink-conf.yaml

33行修改为主节点

jobmanager.rpc.address: bigdata1

workers

vim /flink-1.14.0/conf/workers

删除原有内容

bigdata2 bigdata3

masters

vim /flink-1.14.0/conf/masters

bigdata1:8081

分发安装目录

退回到flink-1.14.0/的上级目录

scp -r flink-1.14.0/ bigdata2:/opt/module/ scp -r flink-1.14.0/ bigdata3:/opt/module/

启动集群

[root@bigdata1 flink-1.14.0]# ./bin/start-cluster.sh

看看各节点启动状态

============ bigdata1 ===========

3477 StandaloneSessionClusterEntrypoint

============ bigdata2 ===========

1865 TaskManagerRunner

============ bigdata3 ===========

1868 TaskManagerRunner

访问web页面

https://bigdata1:8081

Flink on Yarn模式(生产推荐)

YARN 上部署的过程是:客户端把 Flink 应用提交给 Yarn 的 ResourceManager, Yarn 的 ResourceManager 会向 Yarn 的 NodeManager 申请容器。在这些容器上, Flink 会部署 27 JobManager 和 TaskManager 的实例,从而启动集群。 Flink 会根据运行在 JobManger 上的作业所需要的 slots 数量动态分配 TaskManager 资源。解压压缩包

tar -zxvf /opt/software/flink-1.14.0-bin-scala_2.12.tgz -C /opt/module/

进入解压目录

cd /opt/module/flink-1.14.0/

配置环境变量

vim /etc/profile.d/my_env.sh

#FLINK_YARN HADOOP_HOME=/opt/module/hadoop-3.1.3 export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin export HADOOP_CONF_DIR=${HADOOP_HOME}/etc/hadoop export HADOOP_CLASSPATH=`hadoop classpath`分发配置

分发环境变量

scp /etc/profile.d/my_env.sh bigdata2:/etc/profile.d/my_env.sh scp /etc/profile.d/my_env.sh bigdata3:/etc/profile.d/my_env.sh

分发解压包

scp -r /opt/module/flink-1.14.0/ bigdata2:/opt/module/ scp -r /opt/module/flink-1.14.0/ bigdata3:/opt/module/

使用环境变量

所有节点刷新变量

source /etc/profile

启动 Hadoop 集群

包括 HDFS 和 YARN

start-dfs.sh start-yarn.sh

启动Flink集群

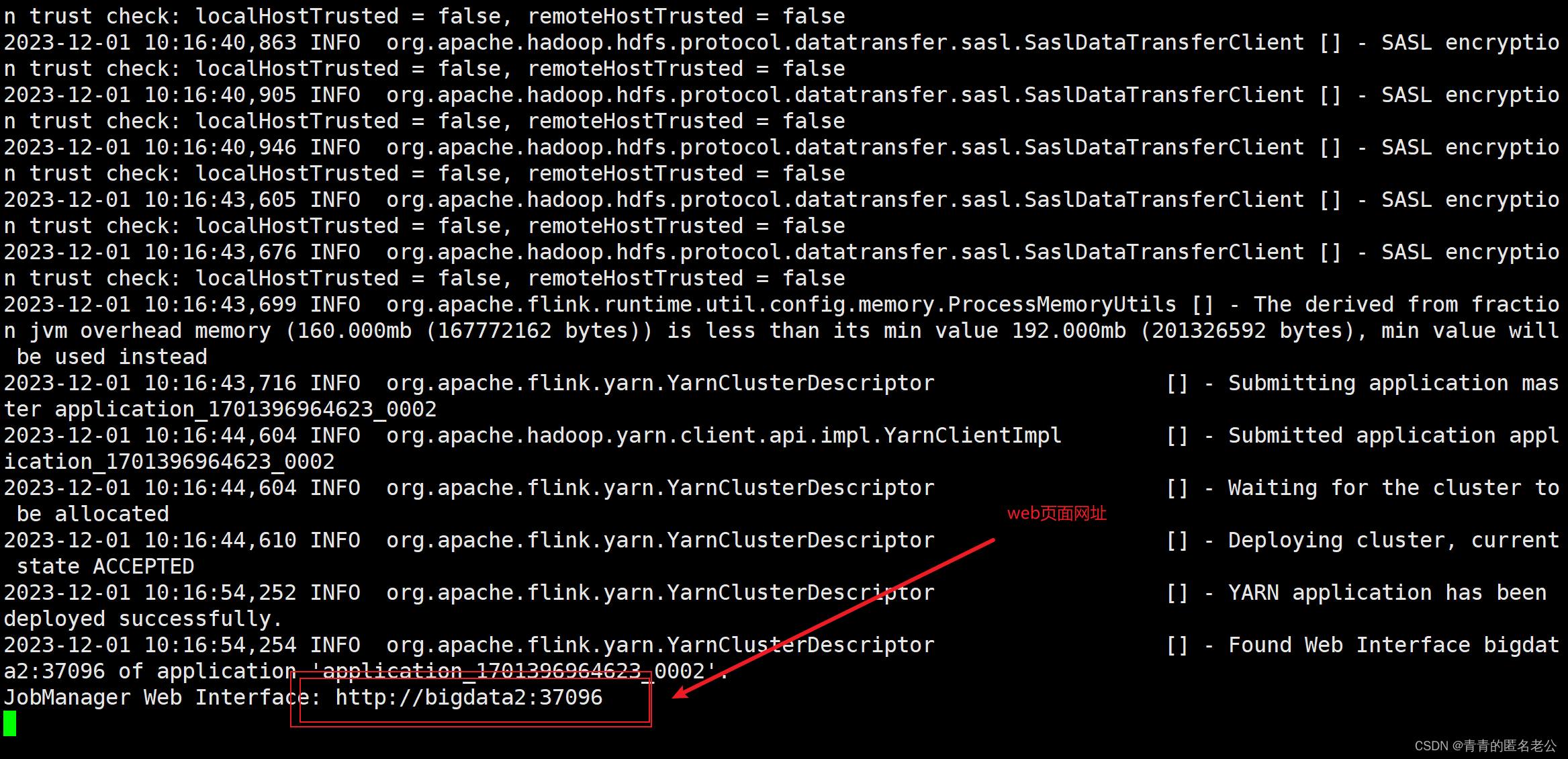

执行脚本命令向 YARN 集群申请资源,开启一个 YARN 会话,启动 Flink 集群。

bin/yarn-session.sh -nm test -d

-

-d:分离模式,如果你不想让 Flink YARN 客户端一直前台运行,可以使用这个参数,

即使关掉当前对话窗口,YARN session 也可以后台运行。

-

-jm(--jobManagerMemory):配置 JobManager 所需内存,默认单位 MB。

-

-nm(--name):配置在 YARN UI 界面上显示的任务名。

-

-qu(--queue):指定 YARN 队列名。

-

-tm(--taskManager):配置每个 TaskManager 所使用内存。

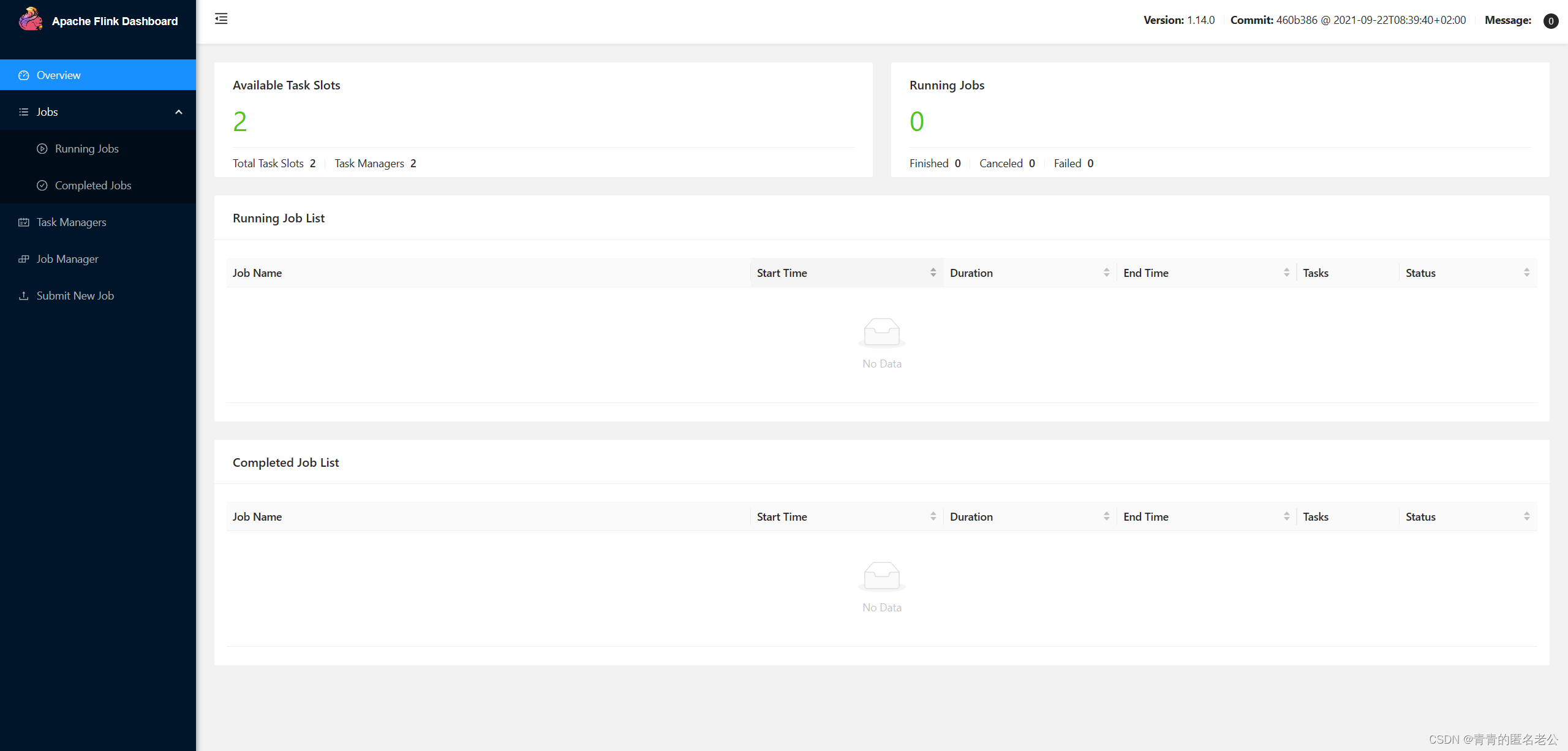

运行结果:

访问web页面

复制启动后生成的web链接这里是 http://bigdata2:37096

conf文件夹中配置文件解读

vim flink-conf.yaml

#flink-1.14.0/conf/flink-conf.yaml

#flink-1.14.0/conf/flink-conf.yaml jobmanager.rpc.address: localhost #jobmanager通用配置(主机名) jobmanager.rpc.port: 6123 #jobmanager通用配置(端口号) jobmanager.memory.process.size: 1600m #jobmanager内存分配 taskmanager.memory.process.size: 1728m #taskmanager内存分配 taskmanager.memory.flink.size: 1280m #可选taskmanager内存分配(不包括进程)不推荐与上面同时配置 taskmanager.numberOfTaskSlots: 1 #taskmanager任务槽数量(并行执行的数量能力) parallelism.default: 1 #并行度(真正运行数量)

vim masters

#flink-1.14.0/conf/masters

localhost:8081 #jobmanager运行端:端口号

vim workers

#flink-1.14.0/conf/workers

localhost #taskmanager运行端

-

-

猜你喜欢

网友评论

- 搜索

- 最新文章

- 热门文章