内容大纲介绍

-

Hadoop框架国内外应用

-

Hadoop的架构图

-

Hadoop集群环境

-

Hadoop集群使用–页面访问

一、Hadoop框架国内外应用

- 国外

- Yahoo的Hadoop机器总节点数目已经超过42000个,有超过10万的核心CPU在运行Hadoop,总的集群存储容量大于350PB,每月提交的作业数目超过1000万个。

- Yahoo的Hadoop应用主要包括以下几个方面:

广告系统支持、

用户行为分析、

Web搜索支持、

反垃圾邮件系统、

个性化推荐

- 国内

- 阿里巴巴的Hadoop集群大约有3200台服务器,大约30000物理CPU核心,总内存100TB,总的存储容量超过60PB,每天的作业数目超过150000个

- Hadoop集群主要为电子商务网络平台提供底层的基础计算和存储服务,主要应用包括:

数据平台系统、

搜索支撑、

电子商务数据、

推荐引擎系统、

搜索排行榜

- Hadoop的组成

- HDFS: 分布式存储框架

- MapReduce: 分布式计算框架

- Yarn: 任务接收和调度器

二、 Hadoop的架构图

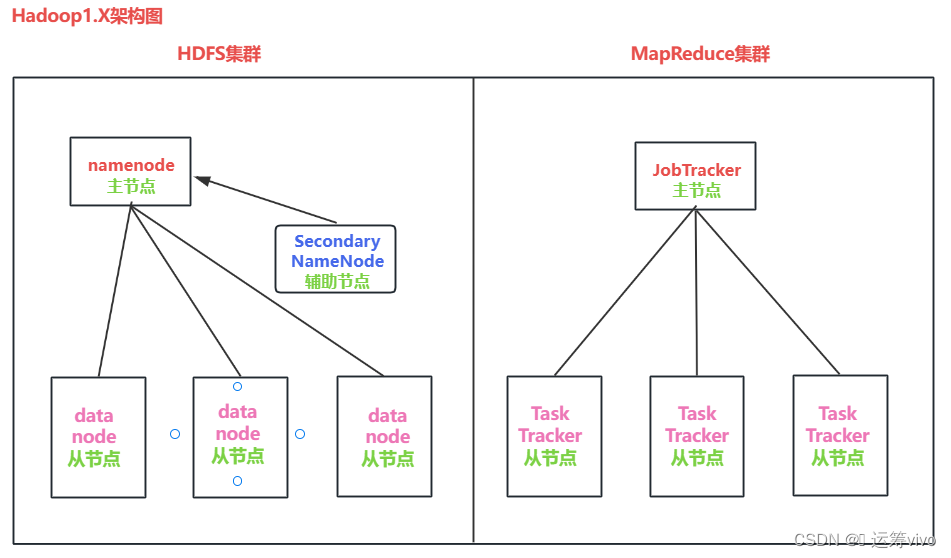

1、Hadoop1.X = HDFS + MapReduce

-

HDFS: Hadoop Distributed FileSystem 分布式文件存储系统

-

HDFS集群架构解释

1、namenode: 主节点 1.管理整个HDFS集群 2.维护和管理元数据 2、什么是元数据(metadata)? 答:描述数据的数据就被称之为: 元数据。例如:图书在哪层,哪个区域,哪个书架 文件的存储路径,大小,时间,权限 3、SecondaryNameNode: 辅助节点→辅助namenode管理元数据的 4、datanode: 从节点 1.维护和管理源文件 2.负责数据的读,写操作 3.定时向namenode报活

-

MapReduce集群架构解释

1、JobTracker:主节点 (1)负责任务的接收 (2)负责任务的调度 (3)负责任务的监控 (4)负责资源的调度和分配 2、TaskTracker: 从节点 负责接收并执行JobTracker分配过来的计算任务 3、JobTracker的任务过于繁重,容易宕机, 存在: 单点故障的问题2、Hadoop2.X, 3.X = HDFS + MapReduce + Yarn

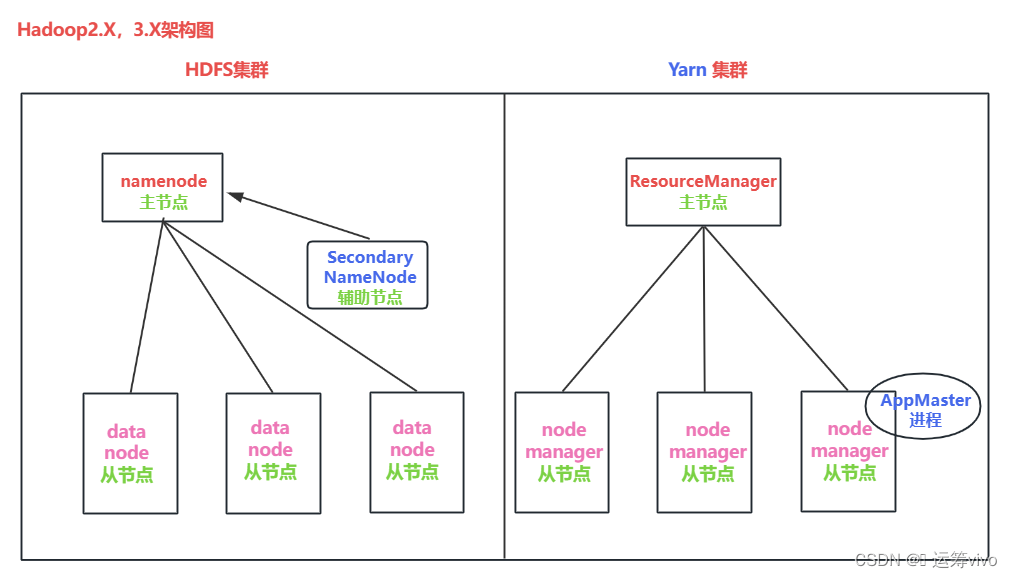

-

Hadoop2.X,3.X的HDFS和1.X一样(架构解释看1.X的HDFS集群架构解释)

-

MapReduce 和Yarn架构解释

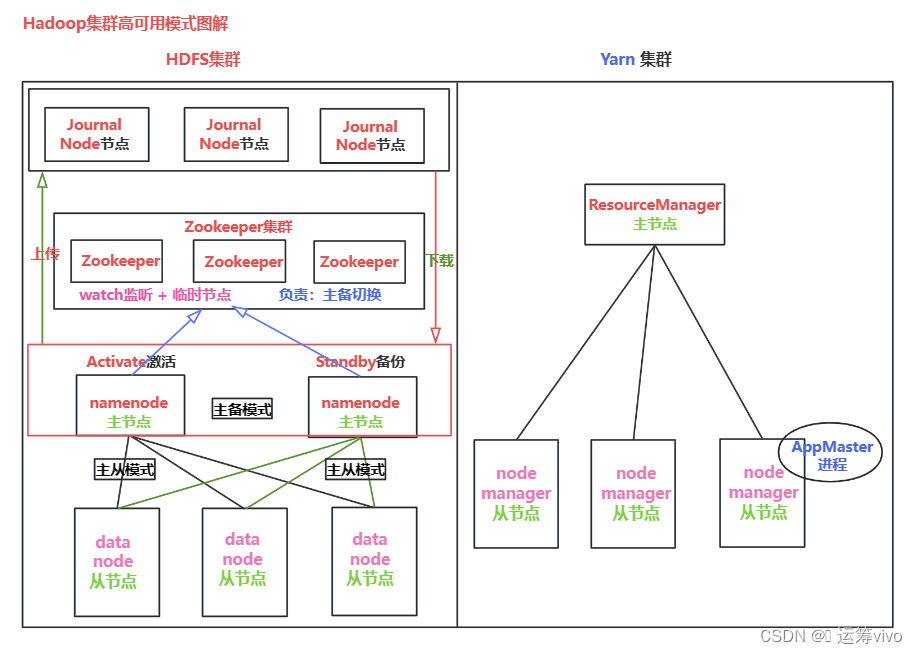

1、ResourceManager : 主节点 1.负黄任务的接收 2.负责资源的调度和分配 2、AppMaster进程:代码级别 1个计算任务 = 1个Application Master进程 由该AppMaster进程来监控和管理该计算任务 并负责向ResourceManager 申请资源 3、nodemanager : 从节点 负责接收并执行ResourceManager分配过来的计算任务 此时已经没有MapReduce集群的概念了,而是代码饭别的程序,即: MR计算任务. 我们只需要用代码编写MR计算任务,然后交由Yarn调度执行即可3、Hadoop集群高可用模式图解

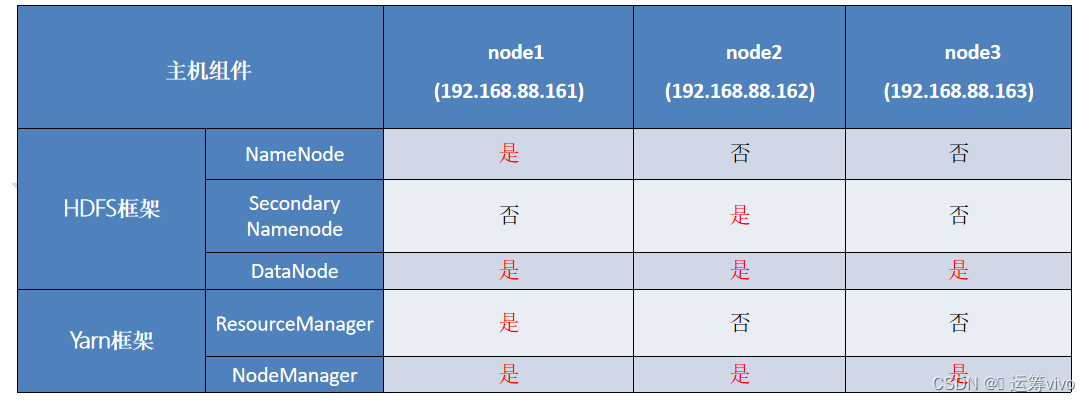

三、Hadoop集群环境搭建

-

搭建方式

-

方式1: Standalone mode 单机模式

把所有的服务(namenode, SecondaryNameNode, datanode, ResourceManager, nodemanager)装到1台机器, 适用于: 学习, 调试.

-

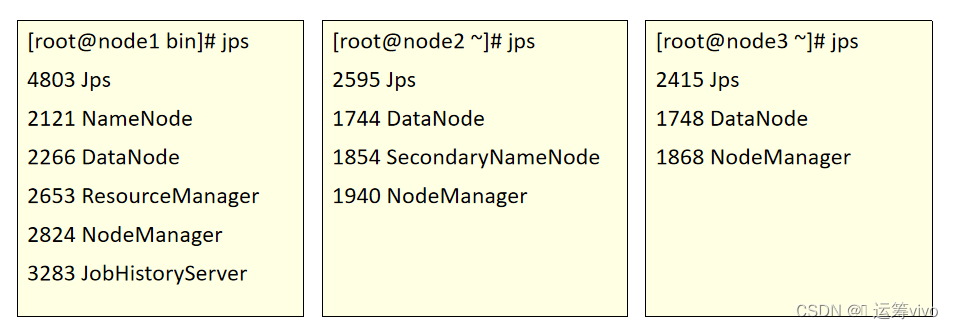

方式2: Cluster mode 集群模式

node1: namenode, datanode, ResourceManager, nodemanager

node2: SecondaryNameNode, datanode, nodemanager

node3: datanode nodemanager

-

使用给的Hadoop集群环境即可.

-

把三台虚拟机都恢复到 07-hive安装完成 这个快照.

-

设置三台虚拟机的硬件, node1的配置可以稍微高一点.

-

启动三台虚拟机, 然后用CRT连接.

ip分别是: 192.168.88.161, 192.168.88.162, 192.168.88.163

账号和密码分别是: root, 123456

-

在node1中执行 start-all.sh 命令, 即可启动Hadoop集群.

-

然后在node1中单独运行 mapred --daemon start historyserver 启动历史服务.

-

然后在三台虚拟机中分别输入 jps 查看服务, 具体如下:

-

之后就可以在浏览器中输入如下的的端口号进行访问了.

* HDFS的WebUI界面: 192.168.88.161:9870 细节: 如果是Hadoop2.X, 端口号是: 50070 * Yarn的WebUI界面: 192.168.88.161:8088, 只记录本次启动Hadoop集群至关闭, 所有的计算任务. * 历史服务的WebUI界面: 192.168.88.161:19888, 记录Hadoop从搭建好至现在, 所有的计算任务.

-

如果想在浏览器中直接通过 域名的方式直接访问上述的WebUI界面, 则需要配置下: 域名映射.

# 域名映射的意思是: 我们只写域名, 底层会被自动解析为对应的IP地址. # Linux系统配置域名映射, 具体步骤如下, 但是不用你做, 我都给你配置好了. vim /etc/hosts # 在上述文件的最后追加如下的内容 192.168.88.161 node1 node1.itcast.cn 192.168.88.162 node2 node2.itcast.cn 192.168.88.163 node3 node3.itcast.cn # 保存退出, 然后重启Linux系统即可. # windows系统 配置域名映射, 具体步骤如下: 在 C:\Windows\System32\drivers\etc\hosts 文件中, 追加如下的内容: # HiveCluster 192.168.88.161 node1.itcast.cn node1 192.168.88.162 node2.itcast.cn node2 192.168.88.163 node3.itcast.cn node3 # 保存, 关闭hosts文件, 然后重启windows系统即可. # 问: 可能你的C盘的hosts文件不让你修改, 提示权限不够, 怎么办? # 答: 把hosts文件拷贝到桌面, 然后进行修改, 改完之后再拖回来, 选择替换即可.

四、Hadoop集群使用–页面访问

配置完域名映射之后,可以把下面IP(192.168.88.161)换成(node1)

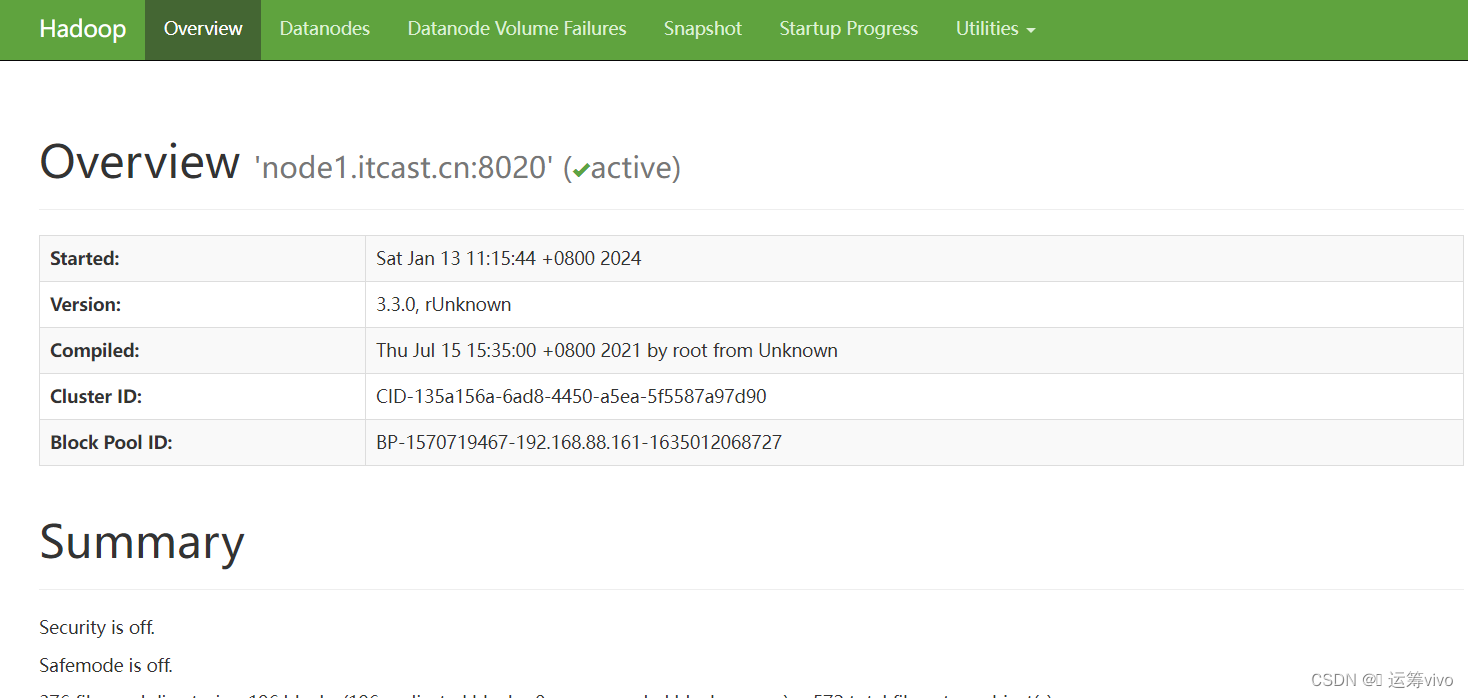

1、查看HDFS页面

启动NameNode.连接URL: http://192.168.88.161:9870

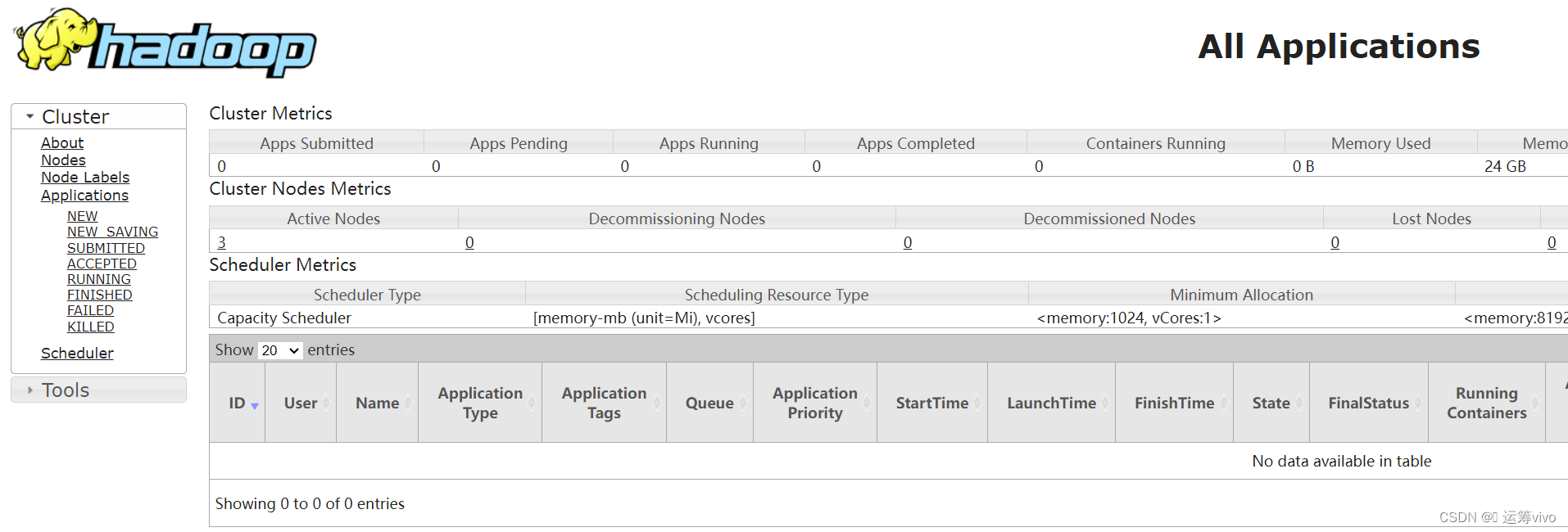

2、查看Yarn页面

启动ResourceManager.连接URL:http://192.168.88.161:8088

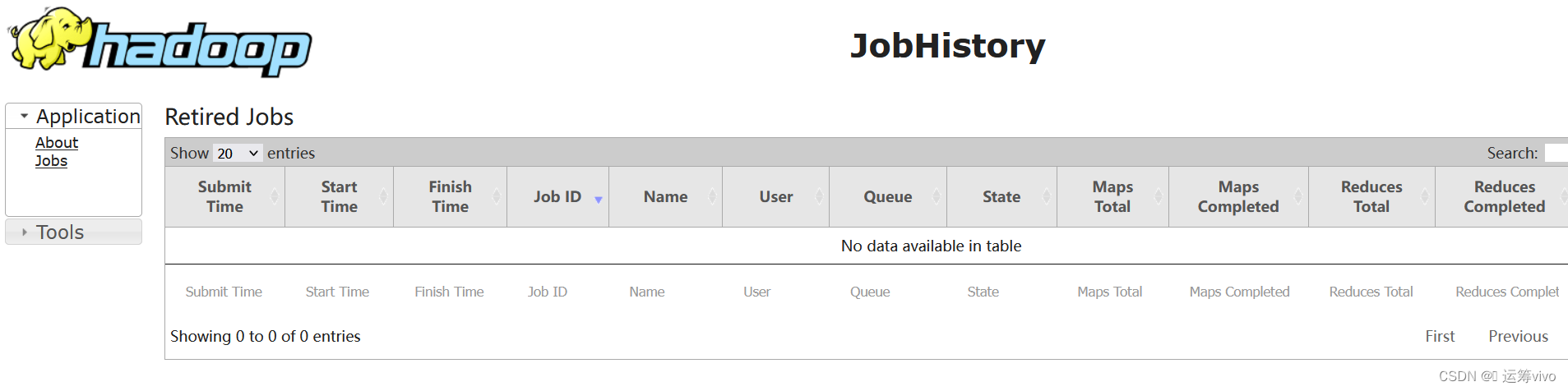

3、查看已经finished的mapreduce运行日志

启动historyserver.连接URL:http://192.168.88.161:19888

-

-

-

-

-

- 国外

猜你喜欢

网友评论

- 搜索

- 最新文章

- 热门文章