一、背景

首先需要掌握 Spark DAG、stage、task的相关概念

Spark的job、stage和task的机制论述 - 知乎

task数量和rdd 分区数相关

running task数=executor-core* num-executors (如果running task 没有达到乘积最大,一般是队列资源不足)

https://www.cnblogs.com/muyue123/p/14036648.html

二、任务慢的原因分析

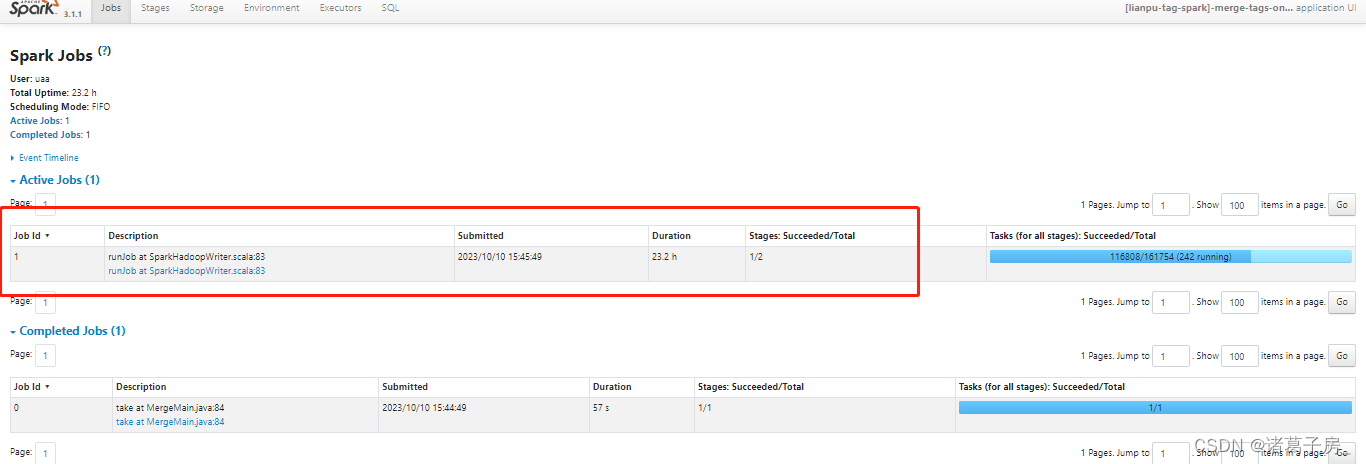

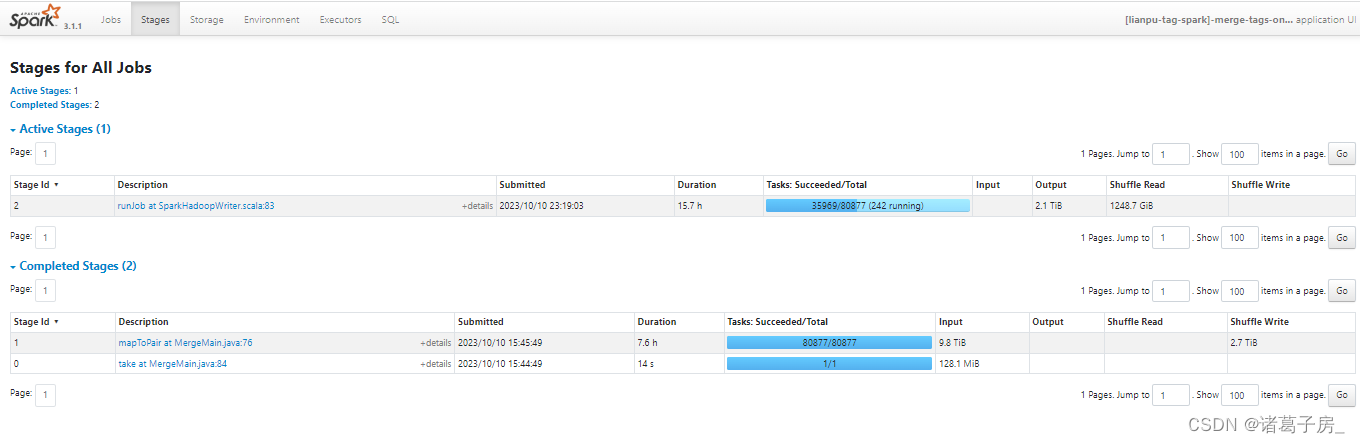

找到运行时间比较长的stage

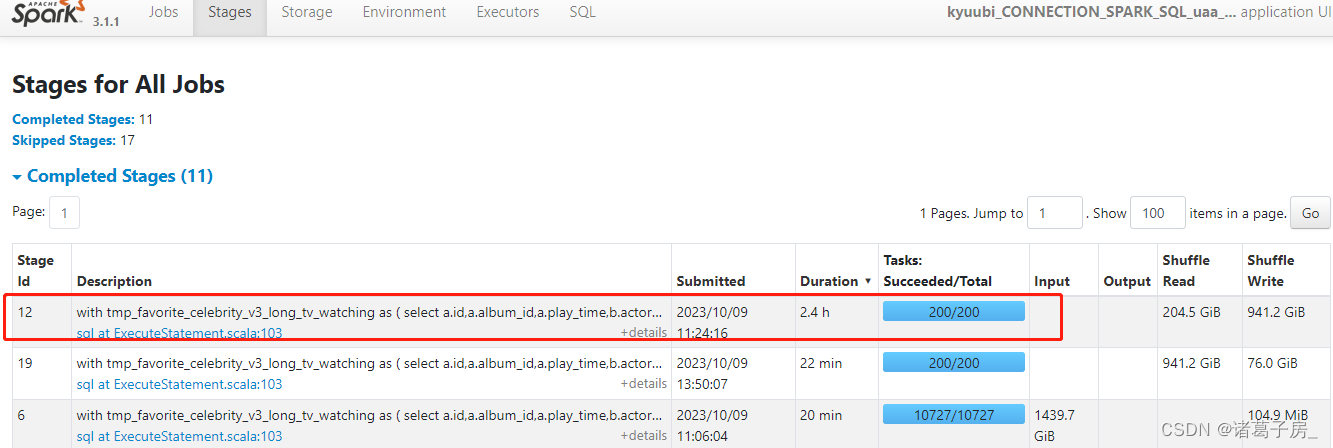

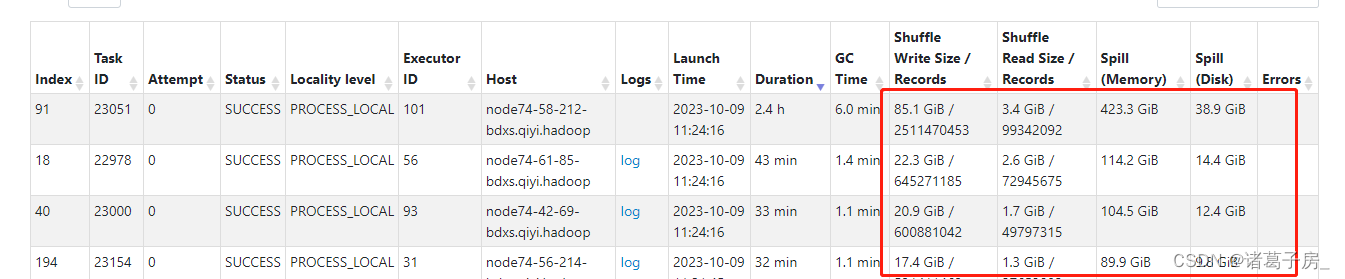

再进去看里面的task

可以看到某个task 读取的数据量明显比其他task 较大。

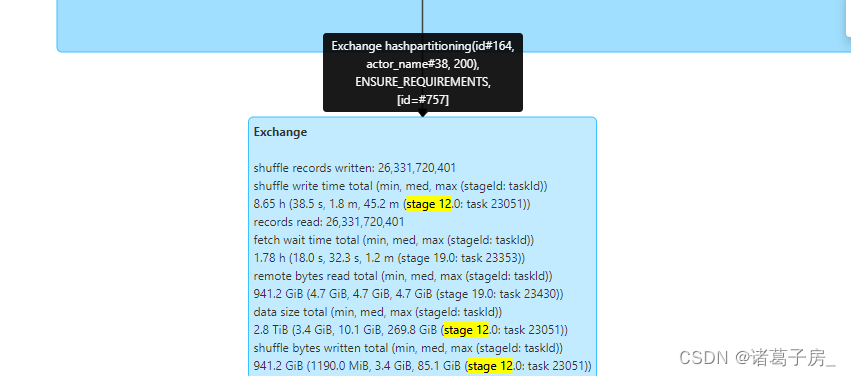

如果是sql 任务进入到 SQL 页面看到 对应的执行卡在哪里,然后分析,如下图是hash id、actor_name,可以看到是group by 数据有倾斜。

group by 数据倾斜问题,可以参考hive group by 数据倾斜问题同样处理思路。

https://zhugezifang.blog.csdn.net/article/details/127447167

猜你喜欢

- 13小时前[Flink] Flink On Yarn(yarn-session.sh)启动错误

- 13小时前分布式消息队列:Kafka vs RabbitMQ vs ActiveMQ

- 13小时前打败一切NeRF! 3D Gaussian Splatting 的 简单入门知识

- 13小时前3D Gaussian Splatting:用于实时的辐射场渲染

- 12小时前手机掉厕所怎么办(手机掉蹲厕里了应该怎么处理)

- 8小时前manage是什么意思(manage是什么意思翻译)

- 7小时前互联网理财(互联网理财平台排名)

- 6小时前无痕钉怎么挂图解(无痕钉怎么安装视频)

- 5小时前aabc的词语有哪些大全(aabc式的词语有什么?)

- 1小时前铜钱树图片(铜钱树图片欣赏)

网友评论

- 搜索

- 最新文章

- 热门文章