Apache Spark是一个强大的分布式计算框架,Spark SQL是其组件之一,用于处理结构化数据。Spark SQL可以使用SQL查询语言来查询和分析数据,同时还提供了与Spark核心API的无缝集成。本文将深入探讨Spark SQL的基本概念和用法,包括数据加载、SQL查询、数据源和UDF等内容。

Spark SQL简介

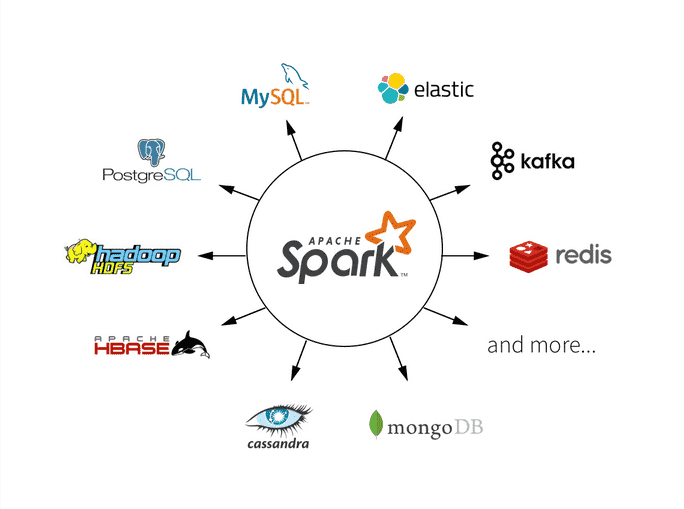

Spark SQL是Apache Spark的一个模块,用于处理结构化数据。它提供了一个高性能、分布式的SQL查询引擎,可以轻松处理各种数据源,包括结构化数据、半结构化数据和非结构化数据。

Spark SQL的主要特点包括:

-

支持SQL查询:您可以使用标准的SQL查询语言来查询和分析数据,无需编写复杂的代码。

-

数据集和数据框架:Spark SQL引入了数据集(Dataset)和数据框架(DataFrame)的概念,这些抽象简化了数据处理操作。

-

丰富的数据源:Spark SQL支持多种数据源,包括Parquet、JSON、Avro、ORC、Hive等。

-

用户定义函数(UDF):您可以定义自己的用户定义函数,以扩展SQL查询的功能。

数据加载

在使用Spark SQL之前,首先需要加载数据。Spark SQL支持多种数据源,包括文本文件、JSON文件、Parquet文件、Hive表等。下面是一些常见的数据加载方法:

1 从文本文件加载数据

from pyspark.sql import SparkSession # 创建SparkSession spark = SparkSession.builder.appName("SparkSQLExample").getOrCreate() # 从文本文件加载数据 data = spark.read.text("data.txt") # 显示数据 data.show()2 从JSON文件加载数据

# 从JSON文件加载数据 json_data = spark.read.json("data.json") # 显示数据 json_data.show()3 从Hive表加载数据

# 从Hive表加载数据 hive_data = spark.sql("SELECT * FROM my_table") # 显示数据 hive_data.show()SQL查询

一旦加载了数据,可以使用SQL查询语言执行各种操作。以下是一些常见的SQL查询示例:

1 查询数据

# 使用SQL查询数据 result = spark.sql("SELECT * FROM data WHERE age > 30") # 显示查询结果 result.show()2 聚合操作

# 计算平均年龄 average_age = spark.sql("SELECT AVG(age) FROM data") # 显示平均年龄 average_age.show()3 连接操作

# 连接两个数据集 joined_data = spark.sql("SELECT * FROM data1 JOIN data2 ON data1.id = data2.id") # 显示连接结果 joined_data.show()数据源与格式

Spark SQL支持多种数据源和数据格式,可以根据需要选择合适的数据源和格式。以下是一些常见的数据源和格式:

1 Parquet格式

Parquet是一种列式存储格式,适合存储大规模数据。可以使用Parquet格式来高效存储和查询数据。

# 读取Parquet文件 parquet_data = spark.read.parquet("data.parquet") # 显示数据 parquet_data.show()2 JSON格式

JSON是一种常见的数据交换格式,Spark SQL可以轻松处理JSON数据。

# 读取JSON文件 json_data = spark.read.json("data.json") # 显示数据 json_data.show()3 Hive表

如果在Hive中存储了数据,可以直接在Spark SQL中查询Hive表。

# 查询Hive表 hive_data = spark.sql("SELECT * FROM my_table") # 显示数据 hive_data.show()用户定义函数(UDF)

Spark SQL可以定义自己的用户定义函数(UDF),以扩展SQL查询的功能。可以使用Python、Scala或Java编写UDF,并在查询中调用它们。

from pyspark.sql.functions import udf from pyspark.sql.types import IntegerType # 定义一个简单的UDF def square(x): return x * x # 注册UDF square_udf = udf(square, IntegerType()) # 使用UDF进行查询 result = spark.sql("SELECT age, square_udf(age) AS squared_age FROM data") # 显示查询结果 result.show()性能优化和注意事项

在使用Spark SQL时,性能优化是一个重要的考虑因素。以下是一些性能优化和注意事项:

1 数据分区

根据数据分区和分布来优化查询性能。合理分区可以提高查询的并行性和性能。

# 使用repartition操作进行数据分区 repartitioned_data = data.repartition(4)

2 缓存数据

对于频繁使用的数据集,可以使用cache或persist操作将数据缓存到内存中,以避免重复读取。

# 缓存数据到内存中 data.cache()

3 使用合适的数据格式

选择合适的数据格式和压缩算法可以显著提高查询性能和存储效率。

4 合并查询

合并多个查询操作可以减少数据扫描和计算开销,提高性能。

总结

Spark SQL是一个强大的工具,用于处理结构化数据,并提供了强大的SQL查询能力。本文深入探讨了Spark SQL的基本概念和用法,包括数据加载、SQL查询、数据源和UDF等内容。

希望本文能够帮助大家更好地理解和使用Spark SQL,并在数据处理和分析任务中发挥其强大的功能。

猜你喜欢

- 13小时前项目分享:基于大数据的股票数据分析系统设计与实现

- 13小时前kafka服务器连接出现:[NetworkClient.java:935] [Producer clientId=producer-1] Node -1 disconnected原因分析

- 13小时前Hive的更新和删除

- 13小时前Flink SQL

- 13小时前将网页数据读入数据库+将数据库数据读出到网页——基于python flask实现网页与数据库的交互连接【全网最全】

- 8小时前欧多桑(欧多桑火锅)

- 8小时前自然景观资料(自然景观资源有哪些)

- 3小时前查征信去哪个银行(查征信去哪个银行位置)

- 2小时前传说地下城怎么进(dnf传说在哪里做)

- 45分钟前报关证(报关证考试报名条件)

网友评论

- 搜索

- 最新文章

- 热门文章